Dom Oriolo: A Caixa Preta da Inteligência Artificial

Dom Edson Oriolo - Bispo da Igreja Particular de Leopoldina MG

A questão levantada me levou a uma reflexão mais profunda sobre a misteriosa "caixa preta" da inteligência artificial. Essa "caixa preta" representa a capacidade dos programas de IA de gerarem habilidades ou respostas de forma inesperada e veloz, a partir de intenções, instruções, informações e interações por meio de prompts, que direcionam a criação de conteúdos, imagens, áudios, vídeos e códigos. A ausência de transparência, de ética e de supervisão humana no funcionamento desses algoritmos suscita preocupações práticas significativas em relação aos resultados apresentados, exigindo avaliação e questionamentos criteriosos.

A IA pode ter muitos dados sobre um candidato, várias paróquias, mas falta-lhe o conhecimento mais personalizado do indivíduo e suas circunstâncias. Se assim não fosse, poderíamos pedir a IA que escolhe nossos governantes. Ela faria uma escolha ideal, e não real ou existencial. As habilidades e as qualidades de alguém passa pelo crivo do conhecimento que se tem dele ou do lugar onde já exerceu atividade e onde exercerá a nova missão. A capacidade de discernimento é exclusiva do ser humano, embora alguns possam ter adquirido maior ou menor conhecimento.

O renomado historiador israelense Yuval Noah Harari, em seu livro "Nexus", nos adverte sobre os perigos da inteligência artificial. Ele destaca que, embora a tecnologia da informação tenha atingido um nível de sofisticação sem precedentes, estamos perdendo a capacidade de dialogar. A crescente polarização e a falta de confiança mútua impedem-nos de nos conectar com os outros e de compreendê-los. Diante desse cenário, questiona-se o valor de tanta tecnologia avançada se não conseguimos estabelecer um diálogo significativo. Harari ressalta que, embora a inteligência artificial demonstre notável capacidade, sua natureza a torna uma ferramenta potencialmente perigosa, a menos que seja rigorosamente controlada por meio de dados e informações precisas. Portanto, é crucial manter o senso de realidade e não entregar o controle total de nossas vidas a essa tecnologia.

Assim sendo, Harari alerta sobre o uso da tecnologia em seu estágio de desenvolvimento atual, indicando que IA é baseada em informação. Ele afirma “informação não é conhecimento. A maior parte de informação é lixo. Conhecimento é um tipo raro e caro de informação”. Esse pensamento de Harari nos faz entender que vivemos em uma era onde os algoritmos, sequências de instruções que orientam a tomada de decisões por computadores, permeiam diversos aspectos de nossas vidas. No entanto, a crescente dependência de algoritmos complexos, especialmente aqueles que alimentam a IA, suscita preocupações significativas. Um dos principais desafios é o fenômeno da “caixa preta” da IA. A falta de transparência, ética e supervisão humana levanta preocupações sobre viés ideológico e preconceituoso, além da responsabilidade.

A dependência cega em algoritmos que operam como “caixas pretas” traz riscos significativos em diversas áreas, exigindo uma análise cuidadosa de suas aplicações. A IA pode auxiliar no diagnóstico de doenças, mas a falta de transparência algorítmica exige validação de um médico ou vários especialistas para evitar erros de tratamento, com graves consequências para os pacientes. Na justiça criminal, a IA pode sugerir sentenças, mas, para evitar injustiças e discriminações, a decisão final deve passar pelo crivo de jurados e juízes. Na triagem de currículos por IA (análise de currículos ideológicos), pode-se reproduzir vieses existentes, discriminando candidatos com base em gênero, estética, local onde moram, raça ou origem social, limitando oportunidades de emprego.

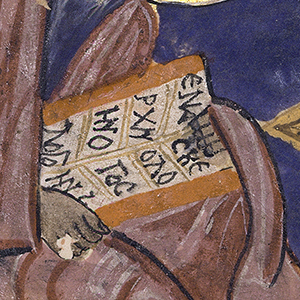

Diante dos resultados obtidos, por meio dos prompts e da não compreensão do funcionamento interno da "caixa preta" da IA, é imperativo que utilizemos essas informações com transparência, ética e supervisão humana, visando maximizar os benefícios e minimizar os riscos. A análise criteriosa dos resultados apresentados pelos algoritmos é fundamental. Devemos aprofundar a investigação desses resultados com transparência e honestidade, garantindo que suas informações sejam compreensíveis e explicáveis. Como nos lembra a passagem bíblica: "Porque tudo o que é secreto será revelado, e tudo o que está escondido será conhecido e virá à luz" (Lc 8,17).

Além disso, é crucial que adotemos uma postura ética em relação às informações fornecidas pela IA evitando discriminação e assegurando que a tecnologia seja empregada para o bem comum. Nos adverte papa Francisco: “o uso das tecnologias ampliou as possibilidades, mas é importante que elas não acabem por substituir a imaginação do homem, criado à imagem e semelhança de Deus”. No entanto, a sabedoria das cartas de São Paulo nos convida a ter fé e buscar um futuro melhor, seja como cristãos ou como seres humanos. Para garantir que a inteligência artificial (IA) seja usada de forma correta, precisamos sempre da supervisão de pessoas. Como diz a Bíblia, em 1 Tessalonicenses 5,21: "Examinem tudo; retenham o que é bom." Isso significa que devemos sempre analisar as informações da IA para evitar erros e garantir que ela ajude a todos.

Obrigado por ter lido este artigo. Se quiser se manter atualizado, assine a nossa newsletter clicando aqui e se inscreva no nosso canal do WhatsApp acessando aqui