Paolo Benanti: Antiqua et Nova invite à se poser les bonnes questions

Andrea Tornielli – Cité du Vatican

«Un document qui nous dit: c'est peut-être le moment de poser des questions avant de donner des réponses». C'est avec ces mots que le frère Paolo Benanti, professeur à l’université Grégorienne, expert en bioéthique et en éthique des technologies, et président de la Commission pour l'étude de l'impact de l'intelligence artificielle sur le journalisme et l'édition de la présidence italienne du Conseil - «photographie», qualifie la note Antiqua et Nova des dicastères de la Doctrine de la foi et pour la Culture et l’Éducation, portant sur la relation entre l'intelligence artificielle et l'intelligence humaine.

Quelle est, selon vous, la nouveauté de ce document?

C'est une prise de conscience de la part de la pensée croyante qui a aussi pour but d'accompagner l'Église dans la vie de la société. Plus nous nous interrogeons sur cette machine capable de se substituer à une partie de la décision humaine, plus nous nous interrogeons inévitablement sur l'identité même de l'être humain et sur l'unicité qui le caractérise, c'est-à-dire sur ce qui fait de nous des créatures en relation avec un Créateur. La véritable nouveauté de ce texte est de nous placer dans la bonne perspective pour nous interroger sur notre identité et notre capacité à contribuer à protéger et cultiver le monde qui nous a été confié par le Créateur.

L'intelligence artificielle devient donc une opportunité de s'interroger sur ce que nous sommes vraiment?

C'est une excellente nouvelle: il y a encore 10 ou 15 ans, ce type de questions sur l'être humain semblait éclipsé. Nous avions des décisions politiques qui assimilaient effectivement certaines espèces de grands singes à la personne humaine, ou qui refusaient l'identité de personne à l'embryon ou à ceux qui vivaient la phase terminale de leur vie. Ce qui semblait être une question à classer dans le passé fait soudain, grâce au travail de l'humanité, un retour en force dans le débat public et dans l'intérêt mondial. Cette question a une double signification: d'une part, elle est anthropologique, comme le souligne bien le document; d'autre part, elle a indubitablement des conséquences sociales et nous pouvons donc déjà imaginer qu'elle sera développée dans le cadre de la doctrine sociale de l'Église.

Quelle est la différence entre l'intelligence dite artificielle et l'intelligence humaine?

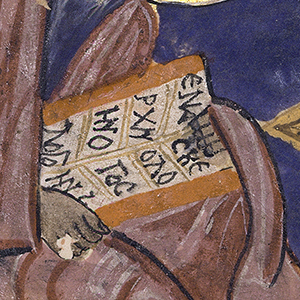

C'est précisément la nature humaine -qui est difficile à contenir dans une définition ou un périmètre prédéterminé- qui nous amène à dire que lorsque nous parlons de l'Homme, nous parlons de quelque chose qui est plus facile à décrire dans plusieurs de ses dimensions. Si nous pensons à la manière dont les Grecs parlaient de l'intelligence, nous devons reconnaître que les mots étaient «pluriels»: Ulysse est défini comme «rusé», «intelligent», avec le mot metis indiquant une forme d'intelligence capable de trouver des solutions à des problèmes pratiques. Lorsqu'ils parlent au contraire d'une intelligence capable de saisir le sens de l'ensemble, les Grecs utilisent le mot nous. Nous avons là, déjà dans les matrices de la pensée occidentale, une intelligence humaine plurielle, capable d'aller dans plusieurs directions. L'intelligence artificielle ne remplace pas toutes ces formes d'intelligence: elle est très bonne pour gagner des jeux, pour trouver des solutions, elle est capable d'un grand metis. Mais le nous, celui qui cherche le sens du tout et qui est capable d'orienter notre vie vers un horizon, un avenir, voire une transcendance, cela n'est qu'humain.

Qu'avons-nous à craindre des applications de l'intelligence artificielle?

Si je peux me permettre une boutade, je dirais que la première chose à craindre est la bêtise naturelle. Car la machine ne se substitue pas à elle-même: c'est toujours nous qui, à la suite de calculs ou de tentatives d'optimisation de certains processus, pourrons utiliser la machine en la faisant choisir à la place de l'Homme. Et une machine aussi puissante, capable de choisir entre une infinité d'options en quelques fractions de seconde, n'est pas toujours en mesure de se substituer à ce que l'on appelle humainement une décision, c'est-à-dire quelque chose qui relève de la sagesse. C'est là toute l'ambivalence d'une IA capable de faire les choses avec une grande rapidité et efficacité, alors que l'Homme, lui, est appelé à s'interroger sur le sens. Peut-être pourrions-nous, ou devrions-nous, craindre tous ces choix qui n'accèdent pas à la décision. Pensons par exemple à la sphère médicale: un diagnostic n'est jamais un simple choix entre des thérapies, mais la prise en charge d'une existence humaine par une autre existence humaine qui lui fait implicitement une promesse de guérison. Nous devons craindre toutes les situations dans lesquelles nous ferions l'expérience d'une humanité diminuée pour permettre une «machinalité» accrue. Au contraire, nous devons promouvoir toutes les applications qui maintiennent cette responsabilité humaine en vie.

Le document insiste beaucoup sur la responsabilité humaine et l'obligation de rendre des comptes. Pourquoi?

Il y a deux grands axes qui donnent lieu à la belle réponse de ce document. Le premier part du point de vue de la foi et s'interroge sur la spécificité humaine du point de vue de la conscience. La constitution conciliaire Gaudium et Spes nous parle de ce lieu intime en nous, où nous entendons une voix qui nous dit à certains moments: fais ceci et évite cela. C'est le sanctuaire où l'Homme entend la voix de Dieu. C'est la matrice de la responsabilité. Mais dans cette conscience croyante, il y a aussi toute une conscience de l'effet de la déresponsabilisation de la prise de décision humaine. De grands écrivains comme Hannah Arendt ont raconté comment, dans les grands massacres du siècle dernier, on a tenté de soustraire la responsabilité à la prise de décision humaine afin de faire partie d'un engrenage qui conduit à une déshumanisation personnelle et sociale maximale. Ces deux capacités humaines, la foi et la raison, main dans la main, peuvent nous aider à voir comment innover l'intelligence artificielle pour qu'elle devienne réellement une source de développement humain.

Malheureusement, nous continuons à voir le rôle des armes autonomes. Que pouvons-nous dire de l'intelligence artificielle appliquée à la guerre?

Pensez à nous, il y a 60 000 ans, lorsque nous avons pris pour la première fois un gourdin dans une grotte. C'était un outil pour obtenir plus de noix de coco et une arme pour ouvrir plus de crânes que les autres. Chaque fois que nous sommes confrontés à la technologie, nous sommes tentés de transformer un outil en arme. Mais nous sommes également plongés dans une histoire de salut -rappelez-vous le prophète Isaïe- dans laquelle les armes peuvent devenir des outils pour cultiver, nourrir et donner la vie. Dans notre histoire de péché et de conversion, ceux qui font la guerre sont fortement tentés d'utiliser des outils dotés d'une technologie aussi puissante. Permettez-moi de vous rappeler que l'IA n'est pas la première forme de technologie autonome utilisée dans la guerre. Pensez aux mines antipersonnel: elles sont autonomes! Un système d'IA peut être défini comme quelque chose qui peut recevoir de l'humain un objectif, et ensuite adapter les moyens pour atteindre cet objectif. Dans une guerre, cependant, il apparait plus que jamais que tous les moyens ne sont pas égaux: depuis la grande tragédie atomique, nous avons compris qu'il y a des moyens à éviter à tout prix. Une machine, contrairement à un être humain, ne se lassera jamais de poursuivre son but et il n'y aura peut-être jamais de trêve si nous ne comptons que sur les machines. Plus la capacité humaine est grande, plus les questions auxquelles nous devons répondre sont radicales.

Lors du sommet du G7 de l'année dernière, le Pape François a déclaré que la décision de mettre fin à une vie humaine ne devrait jamais être laissée à une machine.

La voix du Pape est prophétique. C’est une voix très puissante qui indique une direction. Nous avons besoin d'une extrême précaution, ou plutôt, pour reprendre les termes du document, d'une extrême responsabilité.

L'intelligence artificielle permet aujourd'hui de falsifier la représentation de la réalité. Pensons aux images truquées ou retouchées qui se distinguent de moins en moins des vraies. Ou encore à la diffusion massive de «fake news». Comment contrer ces dérives?

Il semble que pour certains, la vérité soit devenue quelque chose de secondaire et que des récits complètement détachés des faits soient possibles. Toutes les démocraties occidentales reposent sur un postulat fondamental: elles ne peuvent exister en tant que démocraties que si les citoyens sont en mesure de se forger une opinion correcte sur les faits. Par conséquent, la démocratie confère au journaliste un rôle de “serviteur civil”: son professionnalisme est similaire à celui du scientifique qui recherche la vérité ou du juge qui tente d'établir les faits. L'intelligence artificielle pourrait rendre beaucoup moins coûteux certains types de processus de production d'information, mais elle ne rendrait pas une information plus vraie ou plus utile. Pour vivre en démocratie, nous avons besoin d'un journalisme professionnel, et le journalisme professionnel a besoin d'une industrie. Tout cela peut être endommagé économiquement, ou détruit dans sa capacité, par l'intelligence artificielle placée entre de mauvaises mains ou utilisée à de mauvaises fins.

Comment pouvons-nous nous protéger?

Le document nous rappelle la catégorie clé de la responsabilité, et il existe des formes de responsabilité qui, dans l'espace public, prennent la consistance de la loi. Le moment est peut-être venu d'insister sur l'existence d'un droit «cognitif» pour les personnes: celui de savoir quel contenu a été traité par un être humain qui engage sa responsabilité professionnelle, et quel contenu a été produit par une machine. Nous devons peut-être définir quelques garde-fous pour maintenir la vérité de l'information et du journalisme sur la bonne voie. Le document nous dit que c'est peut-être le moment de se poser des questions, avant de donner des réponses.

Merci d'avoir lu cet article. Si vous souhaitez rester informé, inscrivez-vous à la lettre d’information en cliquant ici